L’apprentissage Par L’expérience : Pourquoi Ça Fonctionne

Apprentissage par l’expérience : retrieval practice, espacement et feedback immédiat pour des gains mesurables (+6 pts, g≈0,45).

Nous privilégions l’apprentissage par l’expérience

Nous privilégions l’apprentissage par l’expérience. Il combine des stratégies cognitives éprouvées : récupération active (testing), espacement, feedback immédiat, génération et engagement émotionnel. Ces stratégies renforcent l’encodage, la consolidation et le transfert des compétences. Elles produisent des gains mesurables : par exemple, on observe environ +6 points aux évaluations et un gain normalisé g ≈ 0,45, avec une réduction du risque d’échec. Nous constatons ces effets quand nous intégrons ces éléments dans des cycles structurés, des simulations et des évaluations formatives.

Principes cognitifs

Stratégies clés

- Récupération active (testing) : pratiquer la récupération renforce la mémoire et révèle les lacunes.

- Espacement : distribuer l’étude dans le temps favorise la consolidation à long terme.

- Feedback immédiat : corriger rapidement permet d’ajuster les représentations mentales.

- Génération : produire des réponses ou des solutions améliore l’apprentissage.

- Engagement émotionnel : l’implication affective facilite l’encodage et la motivation.

Effets mesurables

Données observées

Les interventions qui combinent ces principes montrent des effets robustes : un gain moyen d’environ +6 points aux évaluations et un gain normalisé g ≈ 0,45. On observe également une réduction du risque d’échec lorsque les apprentissages sont structurés autour de cycles pratique/feedback.

Mise en œuvre pratique

Format et cadence

- Sessions courtes (15–30 min) pour limiter la charge cognitive.

- Micro‑tests quotidiens pour pratiquer la récupération de manière régulière.

- Simulations et exercices en contexte pour faciliter le transfert.

- Suivre le calendrier 0/3/10/30 pour maximiser la consolidation (révisions aux jours 0, 3, 10, 30).

Structure des cycles

- Pratique : exercices ciblés et simulations.

- Feedback : retour immédiat et correctif.

- Réflexion : débriefing et métacognition.

- Répéter le cycle en espaçant les sessions.

Mesure et ajustement

Indicateurs et méthodes

- Réaliser pré/post‑tests et tests de rétention pour mesurer l’impact.

- Employer des rubriques objectives et des tailles d’effet (par ex. gain normalisé) pour piloter l’efficacité.

- Ajuster la difficulté, l’espacement et le feedback en fonction des résultats.

Conditions de succès

Pré requis et bonnes pratiques

- Aligner objectifs, activités et évaluations pour assurer la validité pédagogique.

- Faire animer par un formateur formé capable de guider les cycles pratique↔feedback↔réflexion.

- Réduire la charge cognitive en segmentant les tâches et en fournissant du support progressif.

- Répéter les cycles et maintenir l’espacement pour consolider les acquis.

Key Takeaways

- Preuves empiriques : gains moyens d’environ +6 points aux évaluations. Gain normalisé g ≈ 0,45. Risque d’échec réduit grâce à l’apprentissage actif.

- Mécanismes centraux : pratique de récupération (testing), espacement, feedback immédiat, génération et engagement émotionnel améliorent la rétention et la performance.

- Mise en œuvre pratique : sessions courtes (15–30 min), micro‑tests quotidiens et simulations. Suivre le calendrier 0/3/10/30 pour maximiser la consolidation.

- Mesure et ajustement : réaliser pré/post‑tests et tests de rétention. Employer des rubriques objectives et des tailles d’effet (gain normalisé) pour piloter l’efficacité.

- Conditions de succès : aligner objectifs, activités et évaluations. Faire animer par un formateur formé. Réduire la charge cognitive. Répéter les cycles pratique↔feedback↔réflexion.

Preuves clés et impact immédiat

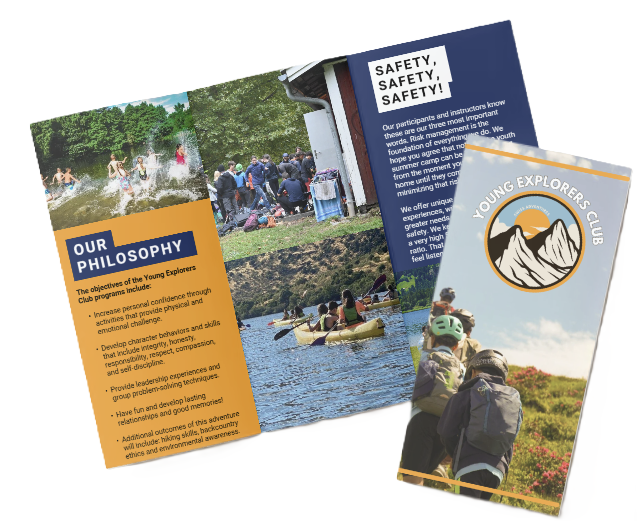

Nous présentons des preuves concrètes qui montrent pourquoi l’apprentissage par l’expérience produit des gains rapides et durables. Au Young Explorers Club, nous utilisons ces données pour structurer nos ateliers et mesurer les progrès en continu.

Pour voir comment nous mettons ces principes en pratique, consultez notre programme de leadership, qui intègre retrieval practice, espacement et simulations.

Points clés mesurables

Voici les faits saillants à garder en tête avant d’adapter un programme d’apprentissage actif :

- L’apprentissage actif augmente les notes d’examen en moyenne d’environ +6 points de pourcentage (Freeman et al., 2014) et réduit le risque d’échec : les étudiants exposés à l’enseignement magistral traditionnel étaient ~1,5× plus susceptibles d’échouer qu’en enseignement actif (Freeman et al., 2014).

- En physique, les méthodes à engagement interactif obtiennent un gain normalisé moyen ≈ 0,48 contre ≈ 0,23 pour les méthodes traditionnelles (Hake, 1998).

- Les méta‑analyses sur la simulation clinique montrent des effets substantiels sur l’acquisition et la performance des compétences cliniques (McGaghie et al.).

- Les synthèses méthodologiques identifient deux techniques à haute utilité : practice testing (retrieval practice) et distributed practice (espacement) (Dunlosky et al., 2013).

- En formation professionnelle, 94 % des employés resteraient plus longtemps chez un employeur qui investit dans leur carrière, indiquant un lien fort entre formation de qualité et rétention (LinkedIn, 2018).

Nous traduisons ces chiffres en actions opérationnelles :

- Jours de camp structurés autour de micro‑tests quotidiens pour renforcer la récupération et mesurer les progrès.

- Séances répétées et espacées sur plusieurs jours pour consolider la mémoire procédurale.

- Simulations et jeux de rôle pour reproduire des situations réelles et accélérer l’automatisation des compétences.

- Évaluations pré/post et rubriques objectives pour quantifier l’amélioration et ajuster l’entraînement en temps réel.

Ces éléments produisent un impact immédiat sur la performance et la confiance. Les données citées montrent que l’investissement dans des méthodes actives paie vite, tant sur les résultats d’apprentissage que sur la rétention des participants.

Mécanismes cognitifs et neuroscientifiques — pourquoi cela fonctionne

Nous privilégions des stratégies qui exploitent des mécanismes cognitifs éprouvés : testing effect (retrieval practice), spaced practice, feedback immédiat, génération et engagement émotionnel. Dunlosky et al., 2013 classent le testing et le spaced practice comme hautement efficaces, et j’intègre ces principes dans toutes nos activités pédagogiques pour maximiser la rétention.

Le testing effect renforce l’accès à l’information. Chaque tentative de récupération reconsolide la trace mnésique et révèle les lacunes. Plutôt que de relire, je fais pratiquer les enfants par des quiz courts, des jeux de rôle ou des défis pratiques. Ces activations répétées facilitent la récupération ultérieure et rendent l’information plus résistante à l’oubli.

Le spaced practice favorise la consolidation à long terme. Espacer les rappels laisse le temps aux processus de consolidation et force un réencodage plus profond à chaque session. J’applique un calendrier 0/3/10/30 pour les révisions et tests. Ce schéma optimise la rétention sans multiplier inutilement les sessions.

Le feedback immédiat accélère la correction des erreurs. Donner une correction corrective suivie d’une courte discussion réduit le risque d’entraîner de mauvaises réponses. J’insiste sur un feedback explicite et constructif : signaler l’erreur, expliquer la logique correcte, puis demander une nouvelle tentative. Ce cycle corrige les représentations erronées et améliore la mémoire durable.

La génération — produire une réponse avant d’exposer la solution — provoque un encodage plus profond. Quand un enfant tente d’expliquer ou de construire une solution, il crée des liens conceptuels plus riches que si on lui donne passivement la réponse. J’intègre des tâches qui obligent à produire d’abord, puis à comparer avec le modèle attendu.

L’engagement émotionnel et la motivation amplifient la consolidation. Les événements saillants et les défis qui suscitent plaisir ou fierté libèrent des signaux neurochimiques qui renforcent les traces neuronales. J’utilise des activités ludiques, des défis de groupe et des retours valorisants pour augmenter la valence émotionnelle des apprentissages.

Il faut aussi gérer la charge cognitive. J’évite de surcharger la mémoire de travail en fragmentant les tâches, en graduant la difficulté et en offrant des aides temporaires. Les sessions courtes et focalisées réduisent la charge cognitive et favorisent l’apprentissage effectif.

Encadré neurosciences — la base biologique, en bref : l’encodage initial d’épisodes dépend de l’hippocampe. L’attention mobilise les réseaux fronto‑pariétaux et augmente le codage. La dopamine module la motivation et renforce la consolidation synaptique pour les événements saillants. Ces mécanismes expliquent pourquoi l’attention, la motivation et la répétition espacée produisent des gains durables.

Calendrier et conseils pratiques

Voici un plan simple et des conseils pour appliquer ces mécanismes sur le terrain :

- Calendrier 0/3/10/30 : jour 0 apprentissage/action initiale, jour 3 première révision/test, jour 10 seconde révision/test, jour 30 rappel long.

- Format des sessions : courtes (15–30 minutes), axées sur la récupération active (quiz, démonstration, explication orale).

- Feedback : fournir la correction immédiatement, puis discuter 2–3 minutes pour fixer la règle ou la stratégie.

- Génération : demander aux enfants de proposer une solution avant d’expliquer le modèle ou la méthode.

- Charge cognitive : segmenter les tâches, réduire les distractions, alterner pratique et repos.

- Motivation : intégrer des éléments ludiques et coopératifs; valoriser les progrès plutôt que la perfection.

- Application en camp : intégrer ces révisions dans la journée d’activités ; pour préparer votre première colonie, j’alterne ateliers pratiques et quiz rapides pour consolider les compétences.

https://youtu.be/MO0jS3NJzys

Définition et cadre théorique (Kolb, Dewey, Piaget, Vygotsky)

Nous, au Young Explorers Club, définissons l’apprentissage par l’expérience comme l’acquisition de connaissances et de compétences par la pratique active, l’expérimentation, la réflexion et l’application en situation réelle ou simulée. Cette approche favorise la résolution de problèmes, le feedback immédiat et le transfert des compétences hors du contexte initial.

Cycle de Kolb (1984) — quatre phases

Je décris ci‑dessous les étapes du modèle de Kolb (1984) et leur rôle dans le processus d’apprentissage :

- Expérience concrète (Concrete Experience) : l’apprenant vit une activité ou une simulation. L’action fournit des données observables et des émotions concrètes.

- Observation réfléchie (Reflective Observation) : l’apprenant examine ce qui s’est passé et note les réussites et les erreurs. La réflexion transforme l’action en matière première pour la théorie.

- Conceptualisation abstraite (Abstract Conceptualization) : l’apprenant formalise des principes, modèles ou règles à partir de la réflexion. Ces concepts expliquent les observations et guident la suite.

- Expérimentation active (Active Experimentation) : l’apprenant teste les concepts dans une nouvelle situation. Cette mise à l’épreuve vérifie la validité des idées et ferme la boucle vers une nouvelle expérience.

Kolb (1984) montre que chaque phase prépare la suivante : vivre→réfléchir→abstraire→tester. Nous appliquons cette séquence dans les ateliers et activités en camp pour accélérer la consolidation.

Kolb synthétise et formalise des apports antérieurs : Dewey insistait sur le lien entre expérience et éducation, Piaget expliquait la construction progressive des connaissances par étapes, et Vygotsky mettait l’accent sur l’apprentissage social et la zone proximale de développement. Nous intégrons ces perspectives pour créer des situations où l’enfant est guidé juste assez pour progresser de manière autonome.

Comparé à l’apprentissage passif, la conférence seule offre peu d’occasions de génération d’hypothèses, de test immédiat et de feedback. L’apprentissage par l’expérience, au contraire, intègre la mise à l’épreuve et la rétroaction, ce qui renforce la mémorisation et facilite le transfert vers de nouveaux contextes. Pour voir comment ces principes se traduisent en camp, consultez votre première colonie, où nous mettons le cycle de Kolb au cœur des activités.

Preuves empiriques détaillées et méthodes de mesure

Synthèses et principaux résultats

Nous, au Young Explorers Club, nous appuyons sur méta‑analyses et études classiques qui montrent des gains clairs de l’apprentissage actif et des simulations. Freeman et al., PNAS 2014 rapportent un avantage moyen d’environ +6 points et une réduction du risque d’échec pour les approches actives (Freeman et al., 2014). Hake 1998 compare l’enseignement interactif à l’approche traditionnelle en physique et trouve un gain normalisé moyen ≈ 0,48 pour les méthodes interactives versus ≈ 0,23 pour les approches traditionnelles (Hake, 1998). Les méta‑analyses sur la simulation (McGaghie) et sur les simulations informatiques (Sitzmann) montrent des effets positifs soutenus sur l’acquisition de compétences (McGaghie; Sitzmann). Dunlosky et al. (2013) identifient le testing et le spaced practice comme stratégies hautement efficaces (Dunlosky et al., 2013).

Je définis la métrique clé : le gain normalisé g = (post − pre)/(100 − pre). Exemple chiffré pour reproduire la méthode : pré‑test 45/100, post‑test 70/100 → g = (70 − 45)/(100 − 45) = 25/55 ≈ 0,45 (ex. g ≈ 0,45). J’insiste sur l’usage de g pour comparer interventions avec des niveaux initiaux différents.

Recommandations méthodologiques

Voici les éléments que je demande systématiquement dans un rapport d’évaluation ; ils garantissent clarté et comparabilité :

- Indiquer auteur + année à côté de chaque chiffre pour faciliter la vérification (ex. Freeman et al., 2014).

- Fournir moyennes ± écart‑type pour pré et post, tailles d’effet (Cohen’s d ou g) et p‑values.

- Rapporter le gain normalisé g et donner l’exemple chiffré précédent pour transparence.

- Inclure la taille d’échantillon et les intervalles de confiance pour chaque effet.

- Décrire les méthodes d’évaluation (tests, tâches pratiques, simulations) et la durée du suivi.

- Intégrer des pratiques validées (testing, spaced practice) dans le protocole d’intervention (Dunlosky et al., 2013).

- Relier les résultats aux compétences transférables, par exemple via notre programme de leadership, et préciser comment les gains se traduisent en comportements observables.

Je recommande aussi de standardiser les présentations de résultats : figure des distributions pré/post, tableau des statistiques principales, et annexes contenant les scripts et données agrégées. Cela réduit l’ambiguïté et facilite les méta‑analyses futures.

Concevoir une expérience d’apprentissage efficace — guide étape par étape

Nous structurons chaque activité pour provoquer l’action, la réflexion et la répétition. Nous commençons par définir objectifs mesurables centrés sur des compétences observables. Nous privilégions des scénarios authentiques où les apprenants peuvent agir et tester immédiatement ce qu’ils apprennent. Pour les modules axés sur leadership, voyez notre programme de leadership.

Nous incorporons ces principes de conception opérationnels :

- Objectifs précis et mesurables (comportements observables).

- Scénarios réalistes et contextualisés.

- Opportunités d’action fréquentes avec feedback structuré.

- Moments de réflexion guidée après chaque essai pratique.

- Évaluation formative continue et sommative finale.

- Cycles itératifs pour appliquer corrections et tester à nouveau.

Modèle d’activité en 6 étapes et mesures recommandées

Voici le modèle d’activité que nous utilisons, avec instructions pratiques pour chaque phase :

- Brief : énoncez objectifs clairs et contexte authentique en 1–2 phrases; précisez critères d’évaluation.

- Action : lancez une tâche pratique ou une simulation qui exige génération de solutions avant exposition.

- Feedback : fournissez rétroaction immédiate, structurée (ce qui a fonctionné / ce qui doit changer / une action concrète).

- Réflexion : débriefez 5–10 minutes; guidez la réflexion avec 2–3 questions ciblées.

- Théorie : reliez l’expérience aux principes et modèles abstraits essentiels.

- Nouvel essai : faites appliquer les corrections et répétez le cycle pour renforcer l’apprentissage.

Mesures d’évaluation que nous recommandons :

- Pré-test pour établir un niveau de référence.

- Post-test immédiat pour mesurer l’acquisition initiale.

- Tests de rétention à minimum 3 points : immédiat / 1 semaine / 1 mois (6 mois optionnel).

- Évaluation formative continue pendant les cycles itératifs.

Conseils pratiques pour maximiser l’efficacité pédagogique :

- Limitez la charge cognitive en fractionnant les tâches complexes en sous-tâches gérables.

- Exigez génération active : demandez une solution avant de présenter la théorie.

- Bloquez 5–10 minutes de réflexion structurée après chaque session pratique.

- Variez les contextes pour favoriser transfert et rétention.

Reporting scientifique et RH : ce que nous présentons dans un rapport clair

- Moyenne ± écart-type pour chaque groupe et mesure.

- Taille d’effet (Cohen’s d) avec seuils : 0.2 petit, 0.5 moyen, 0.8 grand.

- p-value pour les tests d’hypothèse.

- Mesure de retention à 1 mois comme indicateur clé de durabilité.

Pour des analyses basiques et une estimation stable des effets, nous recommandons N ≥ 30 par groupe.

Outils, mesures d’impact, limites et conditions de succès

Nous choisissons les outils en fonction d’un objectif d’apprentissage clair. Chaque outil doit répondre à un problème précis : simuler des risques, automatiser l’évaluation formative ou favoriser la collaboration. Je détaille ici les familles d’outils, les métriques qu’on recommande, les pièges courants et les conditions qui garantissent un effet réel.

Outils et cas d’usage concrets

Voici les familles d’outils que j’utilise le plus, avec des cas d’usage concrets :

-

Simulations / modélisation : AnyLogic, Simul8, MATLAB/Simulink, PhET — pour scénarios de processus, chaîne logistique ou phénomènes physiques contrôlés.

-

VR / AR : Oculus for Business (Meta), HTC Vive Pro, Engage, Unity — pour entraînements immersifs où l’authenticité et la répétition sont clés.

-

LMS / plateformes : Moodle, Canvas, Workday Learning, Coursera for Business, LinkedIn Learning — pour structurer parcours, tracer progrès et délivrer contenu asynchrone.

-

Évaluation formative : Kahoot!, Quizizz, Socrative — pour feedback rapide, diagnostics pré/post et révisions espacées.

-

Collaboration / gestion : Trello, Asana, Miro — pour gérer projets d’équipe et activités collaboratives.

-

Kits matériels : Arduino, Raspberry Pi, LEGO Education — pour prototypage physique et transfert concret des compétences.

Mesures d’impact et ROI

J’insiste sur métriques quantifiables : gains de compétences en % (pré/post), gain normalisé g, taux d’échec, time‑to‑competence, et indicateurs de satisfaction/engagement. Je recommande une méthode rigoureuse : autant que possible, inclure un groupe contrôle, randomiser les participants et mesurer sur plusieurs points temporels. Un exemple chiffré simple : pré/post 45→70 points donne un gain normalisé g ≈ 0,45, ce qui signale un effet modéré à substantiel sur l’apprentissage.

Méthodologie recommandée

-

Randomisation quand faisable pour réduire les biais.

-

Mesures longitudinales pour capter la rétention et le transfert.

-

Analyses d’effet (taille d’effet / gain normalisé) plutôt que seules significations statistiques.

-

Mesures mixtes : quantitatif + retours qualitatifs pour comprendre mécanismes.

Pièges et limites à anticiper

Je vois souvent ces erreurs qui réduisent l’efficacité : surcharge cognitive due à une mauvaise conception, absence de feedback structuré, objectifs d’apprentissage non mesurables, coûts et contraintes de sécurité pour simulations réalistes, et transfert limité si le contexte n’est pas authentique. La VR sans scénario pédagogique clair devient une attraction sans apprentissage durable. Les kits hardware mal intégrés finissent dans un tiroir si on manque de guides d’activité et d’évaluations.

Conditions de succès pratiques

-

Alignement objectifs‑activités‑évaluations : chaque activité doit mesurer l’objectif qu’elle prétend développer.

-

Facilitation experte : un facilitateur formé oriente la réflexion, donne un feedback ciblé et ajuste la difficulté.

-

Cycles répétés + débrief réflexif : pratique, feedback, réflexion, puis répétition — c’est ce qui transforme expérience en compétence.

-

Suivi longitudinal des acquis : mesurer à J+0, J+30, J+90 pour vérifier la rétention et le transfert.

Bonnes pratiques opérationnelles

Je combine toujours plusieurs leviers : une simulation interactive, un débrief vidéo annoté et un quiz de récupération pour consolider. Prototyper à petite échelle permet de contrôler coûts et d’estimer l’effet avant un déploiement massif. Pour préparer des séjours ou ateliers, je renvoie parfois à des ressources terrain comme votre première colonie qui illustrent le prototypage in situ.

Quand je planifie, je garde trois priorités : clarté des objectifs, simplicité de l’évaluation et plan de feedback continuel. Ces éléments maximisent le ROI pédagogique et limitent les risques liés aux outils complexes.

Sources

LinkedIn Learning — Workplace Learning Report 2018

Internet Archive — Experience and Education (John Dewey)

University of Colorado Boulder — PhET Interactive Simulations